能够生成去年引起话题的真实图像的比根变得有名了,相关论文被ICLR 2019作为Oral论文收录。 今天,Andrew Brock宣布,论文更新版上传,模型架构更新的——网络深度为4倍,模型参数仅为一半。 Andrew Brock还指出,新的BigGAN(biggan-deep )训练速度比原版快,FID和IS比原版好,新的biggan比原版更难,特别是在128x128分辨率的图片上。

论文链接: https://开放式review.net/pdf? id=B1 xsqj 09光纤网络中心演示地址: https://TF集线器. dev/s? q=bigganColab地址: https://colab.research.Google.com/Github/Tensor flow /集线器/blob /主/辅助/双声道/双声道

据论文作者介绍,BigGAN-deep的预训练模型将在之后发布。

BigGAN 横空出世

BigGAN在去年9月提出后,备受瞩目。 被称为“史上最强大的GAN图像生成器”,图像的目标和背景非常真实,边界自然,图像插值在各帧都相当真实。

这些图片都是BigGAN自动生成的。

这篇论文一发表,就引起了著名的人工智能学家Oriol Vinyals、Ian Goodfellow的关注。 11月,ICLR 2019的论文审查结果发表,这篇BigGAN论文得到了8、7、10的好评。 BigGAN的原版在ImageNet数据集下Inception Score比目前为止最好的GAN模型SAGAN竟然提高了100分以上(接近两倍)!

比根已经被很多研究者“玩坏”了。 把两种不同类型的东西合并起来,比根会产生奇怪的效果。

BigGAN将正则化的思想引入到GAN中,通过及时截断输入先验分布z,大大提高了GAN的生成性能,通过截断隐藏空间,微调了样本的保真度和多样性的权衡。 通过该修正方法,在类条件的图像合成中,可以达到模型当前的最佳性能。

该研究成功地大大降低了GAN生成图像和实际图像之间的保真度和多样性gap。 主要贡献如下:

表明GAN从训练规模中获得了显著的效益,参数大,即使在批量为8倍,取得以前最佳结果的条件下,也能以2倍到4倍的速度训练。 作者引入了两种简单的生成结构变化,提高了可扩展性,修改了正则化方案,提高了条件化(conditioning )和性能。 作为修正方法的副作用,该模型开始遵循“截断技术”。 这是一种简单的采样技术,可以精细控制样本的多样性和保真度。 发现大规模GAN带来的不稳定性,并根据经验对其进行记述。 根据该分析得出的洞察,新技术与现有技术相结合可以减少这种不稳定性,但要实现完全的训练稳定性,必须以明显降低性能为代价。 截止到

BigGAN vs. BigGAN-deep

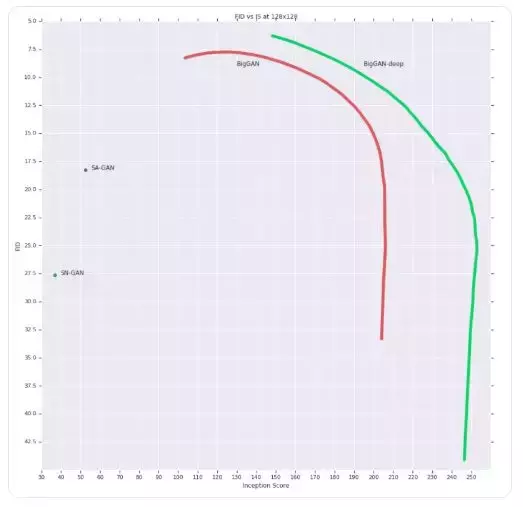

,这篇论文已经出了更新版,模型架构也有所改善。 新模型名为BigGAN-deep,根据名称可以推测两者在深度上似乎有所不同。用128x128分辨率的ImageNet进行训练时,BigGAN可以达到166.3的Inception点数(IS )和9.6的Frechet Inception距离) FID; 另一方面,BigGAN-deep能够达到166.5的IS、7.4的FID,都优于原始的BigGAN。

/p>

BigGAN-deep 与 BigGAN 在 128×128 图像上的 IS 和 FID 对比。

那么 BigGAN-deep 相比于 BigGAN 有何不同呢?

深度增加:BigGAN-deep 的深度是 BigGAN 的 4 倍;参数减少:BigGAN-deep 基于带有 bottleneck 的残差块;训练速度变快性能改进:FID 和 IS 均优于原版。在 128x128 分辨率的 ImageNet 图像上,BigGAN-deep 的 IS 高出 BigGAN 两个百分点,而 FID 比 BigGAN 降低了 2.2。

BigGAN-deep 和 BigGAN 在不同分辨率图像上的评估结果对比。

模型架构

二者的模型架构如下图所示:

BigGAN 模型架构。

BigGAN-deep 模型架构。

从命名上我们可以看到更新版比原版多了个后缀「-deep」。据作者介绍,BigGAN-deep 的深度是原来的 4 倍。从模型架构上来看,BigGAN 模型使用ResNet架构,在生成器 G 中使用了单个共享类别嵌入,对 latent vector z 应用了跳过连接(skip-z)。具体来说,研究者使用了层级潜在空间,使得 latent vector z 按照通道维度被分割为同等大小的块(该研究案例中是 20-D),每个块被级联到共享类别嵌入,并传输到对应的残差块作为条件向量。每个残差块的条件向量被线性投影,以为残差块 BatchNorm 层生成每个样本的 gain 和偏差。偏差投影以零为中心,而 gain 投影以 1 为中心。由于残差块依赖于图像分辨率,因此 z 对于 128 × 128 图像的完整维度是 120,对 256 × 256 图像的完整维度是 140,对 512 × 512 图像的完整维度是 160。

BigGAN-deep 和 BigGAN 的区别主要体现在以下几个方面:BigGAN-deep 使用了 skip-z 条件的一个更简单的变体:作者不是先将 z 分割成块,而是将整个 z 与类别嵌入连接起来,并通过跳过连接将得到的向量传递给每个残差块。BigGAN-deep 基于带有 bottleneck 的残差块,它合并了两个额外的 1 × 1 卷积:第一个卷积将通道数缩减为原来的 1/4,比之前的 3 × 3 卷积开销要小;第二个卷积产生所需数量的输出通道。无论何时通道的数量需要改变,BigGAN 在跳过连接中都依赖 1 × 1 卷积,但 BigGAN-deep 则选择了不同的策略,以在跳过连接中保持 identity。G 中的通道数需要减少,因此研究者保留第一组通道舍弃其他通道,以使最终通道数符合要求。D 中的通道数需要增加,因此研究者将输入通道原封不动地馈入 D,并将其与 1 × 1 卷积生成的其余通道级联起来。至于网络配置,判别器是生成器的完美反映。该模型中对每个分辨率使用两个模块(BigGAN 使用 1 个),因此 BigGAN-deep 的深度是 BigGAN 的 4 倍。尽管深度有所增加,但 BigGAN-deep 的参数却远远少于 BigGAN,这主要是因为前者残差块的瓶颈结构。例如,128 × 128 BigGAN-deep G 和 D 分别具备 50.4M 和 34.6M 个参数,而对应的原版 BigGAN 分别具备 70.4M 和 88.0M 个参数。所有 BigGAN-deep 模型在 64 × 64 分辨率、通道宽度乘数 ch = 128、z ∈ R^128 时使用注意力。

BigGAN-deep 效果

目前 BigGAN-deep 尚未开源,但作者已经把新模型的生成图像样本放在了论文所附链接中。

链接:https://drive.google.com/drive/folders/1lWC6XEPD0LT5KUnPXeve_kWeY-FxH002